Choc pétrolier de 1973, pollution, émissions de gaz à effet de serre et changement climatique constituent ce qui est dénommé « crise énergétique ». Mais est-ce bien le cas ? Ne devrait-on pas plutôt parler d’une crise entropique ? Le physicien Guy Deutscher répond à ces interrogations en nous éclairant sur ce terme assez méconnu des profanes.

Cet article initialement publié sous le titre Energy consumption and entropy release in the biospheredans (Lire : Energy consumption and entropy release in the biosphere) a été traduit en français par Alex Lefebvre, étudiant en première année du master LEA parcours Traduction spécialisée multilingue de l’UFR Langues étrangères (Université Grenoble Alpes), sous la supervision d’André Dodeman. Tous ces intervenants sont sincèrement remerciés.

Si la notion d’énergie est un concept assez familier pour la plupart des gens, l’entropie est, quant à elle, considérée comme étant plus difficile à appréhender. L’énergie fait partie du programme d’enseignement tant primaire que secondaire, mais seuls les étudiants en « sciences dures » étudieront réellement la notion d’entropie. Ce manque de connaissances du public à l’égard d’un principe scientifique fondamental, car soi-disant trop compliqué à comprendre pour ceux qui n’ont pas fait des sciences leur vocation, cause de sérieuses difficultés lorsque l’on essaie d’expliquer la nature exacte d’un des problèmes majeurs auquel l’humanité doit faire face. Nous défendrons l’idée qu’il est en réalité assez facile de comprendre que ce problème est plutôt de nature entropique qu’énergétique, et nous nous efforcerons de clarifier les enjeux de cette nouvelle priorité.(Lire : Une brève histoire de l’énergie et Qu’est-ce que l’énergie ?).

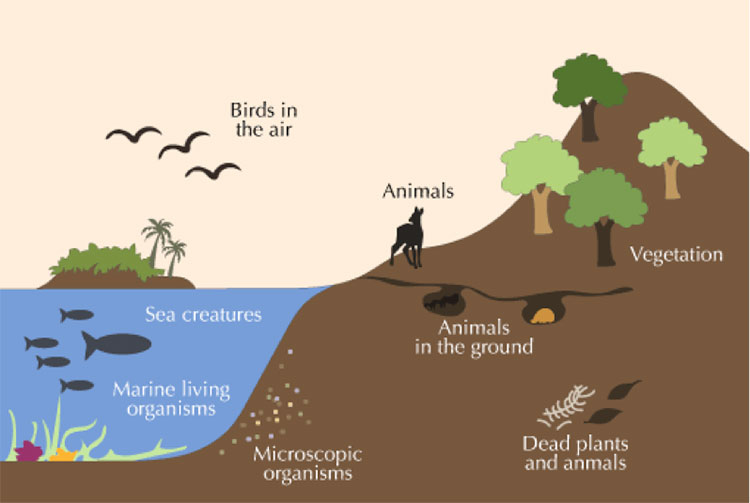

D’un point de vue pédagogique, les notions d’énergie et d’entropie devraient être enseignées conjointement dans les programmes scolaires, plutôt que séparément comme c’est le cas aujourd’hui. La notion d’énergie ayant été découvert avant celui d’entropie, c’est principalement pour cette raison que ce dernier est enseigné plus tard dans le cursus, mais une introduction simultanée est plus que nécessaire lorsque l’on aborde le sujet de l’impact des activités humaines sur la biosphère (figure 1).

Figure 1. Qu’est-ce que la biosphère ? [Source: © Eschooltoday, Https: //eschooltoday.com/earth-system/the-biosphere.html]

Il est évident qu’afin de pouvoir maintenir une structure en vie, qu’elle soit individuelle ou sociétale, un apport en énergie est nécessaire. Un tel apport est nécessaire afin de contenir au maximum l’augmentation de l’entropie, ou désordre, dans un système clos. Que ce soit à l’intérieur de nos corps ou de nos sociétés, l’ordre est maintenu grâce à un approvisionnement constant en énergie qui va permettre de transférer l’entropie à l’extérieur de ces systèmes. Pour un individu, les besoins sont simples : nourriture, chaleur, entre autres. Mais, les sociétés complexes ont des besoins en énergie qui vont bien au-delà de ceux d’une personne lambda.

Ces transferts d’entropie ayant lieu à tous les niveaux ne présentent pas qu’un intérêt pour les experts en thermodynamique. Ils peuvent avoir une application pratique représentant même quelques fois un grave danger. Un des exemples les plus connus est la pollution atmosphérique, car elle peut atteindre des niveaux dangereux tout en couvrant une zone large sur une longue période de temps. La pollution agit, comme décrit dans la loi de Boltzmann, qui énonce l’augmentation de l’entropie à mesure que les molécules peuvent occuper plus d’espace, de manière logarithmique (Lire : Thermodynamique, d’une simple question d’ingénieur à la compréhension de l’irréversibilité). Quand les molécules émises par l’échappement d’une voiture se retrouvent dans l’atmosphère, c’est l’entièreté de cette dernière qui s’offre à elles. Un espace immense qu’elles occuperont dans les moindres recoins à travers une succession de collisions avec les autres molécules ambiantes, car l’augmentation de l’entropie causée par ces chocs aura pour effet de diminuer une forme d’énergie disponible dans la biosphère (l’enthalpie libre). Les molécules de dioxyde de carbone produites par la combustion de charbon, de carburants liquides ou de gaz naturels finissent par se répartir uniformément dans l’atmosphère. La pollution atmosphérique est une conséquence directe de l’augmentation de l’entropie décrite par Boltzmann (figure 2).

Figure 2. Ludwig Boltzmann – Source : Université de Frankfort [domaine publique], via Wikimedia Commons

1. Comparaison de différents moyens de produire de l’électricité du point de vue de l’entropie

Les transferts d’entropie sont un outil extrêmement utile lorsque l’on veut comparer plusieurs manières de produire de l’énergie. L’utilisation de combustibles traditionnels augmente l’entropie de manière bien plus importante que le recours à l’énergie nucléaire, et est donc bien plus dangereuse. D’après une étude récemment publiée par l’Organisation Mondiale de la Santé (OMS), on estime que la pollution atmosphérique a été responsable de la mort prématurée de 7 millions de personnes en 2012. A titre de comparaison, c’est plus que le nombre de décès causés par la production nucléaire sur une période bien plus longue. C’est même plus que le nombre de victimes des bombardements d’Hiroshima et Nagasaki. Un tel écart est une conséquence directe de la loi de Boltzmann. Empêcher la diffusion du dioxyde de carbone et des autres gaz de combustion dans l’atmosphère est tout bonnement irréalisable, alors qu’il est possible de stocker, sous forme liquide ou solide, les combustibles nucléaires usés. Ainsi, les centrales nucléaires n’entrainent qu’une augmentation négligeable de l’entropie. Des fuites sont possibles, mais elles restent l’exception, tandis qu’avec les autres combustibles, elles sont la règle. L’emploi du charbon, du pétrole, ou encore des gaz naturels pour produire de l’électricité représente une menace bien plus grande pour la santé que le nucléaire. (figure 3)

Figure 3. Gaz de combustion dû à l’utilisation de gaz naturels. [Source : Union of Concerned Scientists, https ://www.ucsusa.org/clean-energy/coal-and-other-fossil-fuels/environmental-impacts-of-natural-gas#.W03xotIzaM8]

Les énergies renouvelables n’échappent pas à ce phénomène. Elles représentent une source d’énergie variable qui, si l’on veut mettre en place une production énergétique stable, doit être associée avec des moyens de production plus « classiques ». Bannir complètement le nucléaire et le remplacer par l’énergie solaire ou éolienne avec en complément des centrales électriques à énergies fossiles conduira également à une augmentation de l’entropie, avec ses conséquences sur la santé.

On peut tout de même se demander pourquoi a-t-on tardé à se rendre compte du problème de la pollution atmosphérique (Lire : Debout pour un monde soutenable). Peut-être parce que, comme toutes les formes de transferts d’entropie, la pollution est un phénomène global et variable dans le temps, dont les effets ne sont pas immédiatement visibles à plus grande échelle. A contrario, la consommation d’énergie est un phénomène immédiat et localisé. Lorsque l’on utilise de l’essence dans nos voitures, on sait, tout de suite, que le carburant a disparu : c’est un événement local et instantané. Si l’on veut que la voiture continue d’avancer une fois que son réservoir est vide, il va falloir payer pour refaire le plein. Ce qui nous inquiète dans l’immédiat, c’est combien toute cette affaire va nous coûter. On ne s’inquiétera de payer le prix de cette pollution que bien plus tard. Les molécules de carbone et d’oxyde d’azote, tout comme les microparticules qui sortent de notre pot d’échappement, ne sont pas vraiment au centre de nos préoccupations au volant. Mais une fois que ces molécules se retrouvent dans l’atmosphère, elles vont finir par s’y diffuser. Et rien ne pourra les en empêcher. Et au vu du nombre de voitures en circulation, les particules qui finiront dans nos poumons ne seront surement pas celles que nous avons émises nous-mêmes. Qui donc portera le chapeau ? Et qui paiera pour notre santé et celle des autres ? Que dire également des effets qu’ont certains gaz, comme le dioxyde de carbone, sur le climat ? Combien de générations futures devront subir les conséquences du dérèglement climatique ? Sans parler de la pollution des cours d’eau et des nappes phréatiques, elle aussi inéluctable d’après la loi de Boltzmann. Voilà le genre de questions épineuses soulevées par l’augmentation de l’entropie dans la biosphère. (figure 4).

Figure 4. Pollution [Source : Pikist – libre de droits]

2. La soi-disant « crise énergétique »

Le terme de « crise énergétique » est apparu durant la guerre du Kippour de 1973, notamment à cause de l’embargo pétrolier qui avait suivi. À l’époque, le pétrole était le carburant du futur. Il était moins cher que le charbon et ses réserves étaient abondantes. Les centrales avaient fait la transition du charbon vers le pétrole. On l’utilisait à la place du charbon, plus cher et plus polluant, pour se chauffer. Le nucléaire avait réalisé quelques avancées, mais il ne pouvait pas rivaliser avec un pétrole au prix si attractif. Plus de voitures en circulation signifiait plus de pétrole pour les faire fonctionner. Un embargo pétrolier aussi soudain était un véritable cauchemar pour les nations occidentales (Lire : Géologie et géodynamique des hydrocarbures).

Comme on a pu le voir, ce n’était pas réellement une crise énergétique, mais juste une simple crise pétrolière n’ayant pas duré. Car si en 1975 la majorité des émissions de dioxyde de carbone provenait du pétrole plus que du charbon, la situation actuelle est l’exact inverse. Alors que la consommation pétrolière ne connait qu’une légère croissance, la consommation de charbon, elle, explose, ce dernier étant peu cher et abondant. Les réserves mondiales de charbon devraient être suffisantes pour couvrir nos besoins sur plusieurs siècles (Lire : Charbon minéral, l’industrie ne baisse pas les bras). On exploite de plus en plus le gaz naturel, le gaz de schiste ou le schiste bitumineux (Lire : Gaz naturel, une filière très capitalistique). Le charbon, le gaz naturel, le gaz de schiste et l’huile de schiste sont beaucoup plus disponibles sur nos cinq continents que ne l’est le pétrole. Même sans prendre en compte le nucléaire et les énergies renouvelables, nous ne devrions pas avoir à subir une pénurie d’énergie avant un très long moment. Il n’y a jamais eu de crise énergétique, et il n’y en aura surement pas dans un futur proche.

Le réel danger donc est surtout d’ordre entropique[1], et ses effets sont déjà bien visibles. Mais avant de revenir sur la situation actuelle, jetons un bref coup d’œil à l’histoire de la biosphère en termes d’énergie et d’entropie.

3. L’évolution de l’entropie dans la biosphère

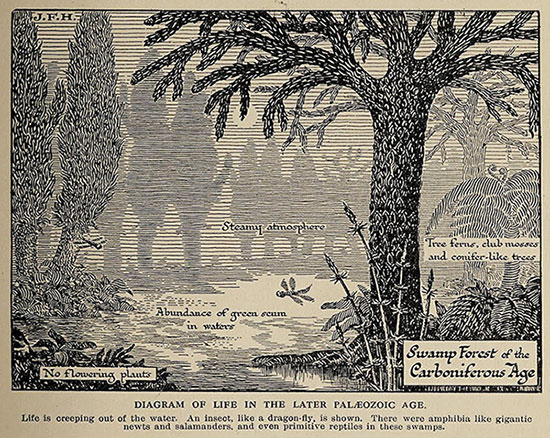

Il y a 500 millions d’années, le taux de dioxyde de carbone présent dans l’atmosphère était 25 fois plus élevé qu’aujourd’hui, la température était d’environ 10 degrés au-dessus de la moyenne actuelle, et il n’y avait aucune plante à l’air libre. L’apparition d’une couche d’ozone a ensuite permis la prolifération de la végétation sur la terre ferme grâce à la photosynthèse, ce qui a progressivement amené à la réduction du taux de dioxyde de carbone dans l’atmosphère et à un abaissement des températures causé par un effet de serre moindre (Lire : Photosynthèse et biomasse). Une partie du bois créé à l’aide de la photosynthèse s’est ensuite transformée en gisements de charbon, notamment durant la période Carbonifère, entre 350 et 250 millions d’années avant notre ère (figure 5). Les gisements de pétrole et de charbon ont également été formés grâce à l’accumulation de matière organique, provenant peut-être d’organismes marins. De manière globale, l’entropie de la biosphère s’est réduite, et la vie a pu foisonner grâce à l’apport énergétique des rayons solaires. Pendant cette longue période de temps, l’entropie dégagée par les organismes vivants et autres transformations chimiques était plus que compensée par cet apport d’énergie solaire.

Figure 5. L’ère Carbonifère [Source: J. F. Horrabin (Illustrateur) [domaine public], Wikimedia Commons]

La nouvelle utilisation massive des combustibles fossiles est en train de renverser cette tendance. L’entropie diffusée dans la biosphère ne peut plus être compensée par la photosynthèse. Un bon indicateur de ce phénomène est l’augmentation du taux de dioxyde de carbone dans l’atmosphère, qui est surveillé de manière très précise depuis 1958 à l’Observatoire du Mauna Loa à Hawaï. Les rapports détaillés de l’évolution de ce taux sur les 500 000 dernières années sont consultables et montrent des variations qui oscillent entre 180 et 280 parties par millions (ppm). En 1958, il était à 315 ppm, soit légèrement au-dessus des variations moyennes. Il se rapproche aujourd’hui des 400 ppm, c’est à dire bien au-delà de ces valeurs. Il ne fait aucun doute que cette augmentation ne correspond en rien aux variations précédentes, et donc qu’elle trouve ses origines dans l’utilisation à outrance des combustibles fossiles par l’homme. Si une telle hausse se maintient, le taux de dioxyde de carbone devrait atteindre les 600 ppm en 2100, soit 2,5 fois plus que la concentration médiane de ces derniers millions d’années. Cela devrait ramener la biosphère au même niveau qu’il y a 100 millions d’années, ce qui donne une idée de l’impact qu’a le recours massif aux combustibles fossiles : cela est d’autant plus marquant qu’il laissera des traces au niveau géologique.

L’accroissement de la concentration du dioxyde de carbone est une mesure de l’entropie que nous émettons de manière globale. Cela nous emmène vers des territoires inexplorés. Durant les 10 000 dernières années, l’humanité a pu profiter d’une période exceptionnelle de stabilité climatique qui a permis à la civilisation de se développer. Personne aujourd’hui ne peut prédire les éventuelles conséquences d’une augmentation aussi forte et rapide du taux de dioxyde de carbone dans l’atmosphère. Le réchauffement climatique n’est qu’une des raisons, et probablement pas la plus importante. L’instabilité climatique serait un candidat plus plausible. Il serait donc prudent, et certains diront même impératif, de réduire nos émissions d’entropie, afin de pouvoir revenir à un état qui permettra à ces dernières d’être compensées par les rayonnements solaires. Il faudrait alors réduire nos émissions de dioxyde de carbone jusqu’à ce que ce dernier retrouve son taux d’il y a 50 ans, c’est-à-dire légèrement au-dessus des fluctuations moyennes, aux alentours de 280 ppm (Figure 6).

Les émissions d’entropies sont liées à la quantité d’énergie que nous consommons, ainsi qu’à l’efficacité des transformations chimiques impliquées (Lire : Energie et climat, la construction des politiques climatiques). Les deux aspects doivent être examinés.

4. De quelle quantité d’énergie avons-nous besoin ?

Sans compter la nourriture, la quantité d’énergie dépensée par personne au Nigéria est de 43 W. Dans les pays développés, elle est généralement une centaine de fois plus élevée. Mais d’où provient cette différence ?

Soient les besoins énergétiques quotidiens d’un foyer de quatre personnes dans un pays de la zone euro. Sans prendre en compte la nourriture, on atteint les 100 kilowattheures (kWh), ce qui correspond à environ 1kW par habitant, soit 20 fois plus qu’au Nigéria (tableau 1). La différence est simple à comprendre : la plupart des Nigérians ne possèdent pas d’appareils électriques, n’utilisent pas d’eau chaude sanitaire, le climat du pays rend le chauffage inutile, l’air conditionné n’est pas très répandu et la plupart des gens n’utilisent pas de voiture personnelle pour leurs déplacements. Notons tout de même que l’énergie dépensée sous forme de consommation de nourriture est la même pour tous, environ 100 W.

| Nourriture

Pour une consommation moyenne d’énergie de 150 W, en supposant un minimum d’activité physique.

|

10 |

| Appareils électriques

On y inclut les réfrigérateurs, machines à laver, téléviseurs, ordinateurs personnels, l’éclairage, entre autres. |

10 |

| Eau chaude

Pour un usage sanitaire |

10 |

| Chauffage domestique

Pour une maison bien isolée d’environ 160 m², où 1 000 litres de carburant ou équivalents, sont consommés chaque année. |

30 |

| Transport

Pour une distance annuelle parcourue de 15 000 km, dans une voiture consommant en moyenne 10 L/100km. On compte 10 kWh d’énergie chimique disponible dans un litre de pétrole.

|

45 |

| Total | 110 |

Tableau 1. Besoins énergétiques quotidiens pour une famille de quatre personnes en kWh

Il y a de quoi être surpris lorsque l’on compare la consommation énergétique à l’échelle d’un foyer à celle de l’échelle de la société : dans un pays de la zone euro et par habitant, la consommation par foyer est cinq fois plus élevée que celle sociétale. Ce facteur de cinq est un problème. Il est essentiel de comprendre pourquoi autant d’énergie supplémentaire est utilisée à l’échelle d’une société plutôt qu’à l’échelle individuelle. L’humanité pourrait se permettre d’utiliser 1kW par personne ; c’était le cas il y a 50 ans avant que le taux de dioxyde de carbone ne commençât à dépasser ses moyennes historiques. Mais elle ne pourra pas se permettre d’utiliser cinq fois plus. Non pas parce que l’énergie nécessaire ne serait pas disponible, mais parce qu’à cause des effets d’une trop grande entropie, le monde suffoquerait par manque d’air respirable et d’eau potable (Lire : Les besoins d’énergie).

L’idée selon laquelle notre monde ne dispose que de ressources naturelles limitées, et qu’il ne peut donc pas subvenir aux besoins d’une population plus grande existe depuis un long moment. Elle est pourtant fausse. Les ressources sont suffisantes pour une population plus nombreuse, au moins pour les quelques siècles à venir (Lire : Charbon minéral : géologie, ressources et réserves et Géologie et géodynamique des hydrocarbures). Le facteur limitant est que l’environnement naturel à faible entropie dont nous avons bénéficié jusqu’à présent est en train de disparaitre rapidement. Ce qui freinera la croissance démographique ne sera pas une pénurie énergétique, mais une augmentation de l’entropie dans la biosphère. Le charbon et autres ressources ne sont pas le problème. Le problème, c’est le volume fini de la biosphère.

Réduire l’énergie consommée à l’échelle des foyers est tout à fait possible : de plus en plus d’appareils électriques économes sont disponibles, les logements sont de mieux en mieux isolés, et les voitures consomment de moins en moins (Lire : Les politiques d’efficacité énergétique : problématiques, moyens et outils d’évaluation). De bon progrès certes, mais cela reste insuffisant. Le plus grand défi est de parvenir à réduire les 4kW utilisés par personne à l’échelle de la société dans les pays développés. En l’état actuel des choses, ces derniers ne sont pas un modèle de développement à suivre pour le reste du monde (Lire : La sobriété énergétique, une nécessité dans la transition énergétique).

5. L’entropie et le deuxième principe de la thermodynamique

On pourrait l’appeler le cauchemar de la ménagère. Elle affronte un génie tout-puissant nommé l’entropie. Celui-ci fait en sorte que si de la poussière a été soigneusement déposée dans le coin d’une des pièces de la maison, cette pièce ainsi que toutes les autres finiront par être empoussiérées. Malheureusement, personne n’a jamais vu la poussière se poser gentiment dans un petit coin par elle-même. Pour cette même raison, les molécules de sel dans l’eau de mer ne se regrouperont jamais de leur propre chef afin de nous laisser une part d’eau potable disponible. Toutes ces situations dépendent de la même loi naturelle que les physiciens appellent le deuxième principe de la thermodynamique : dans un système fermé qui ne reçoit aucun apport en énergie, l’entropie (le désordre) ne peut qu’augmenter, jamais diminuer. L’énergie est conservée, c’est le premier principe de la thermodynamique ; l’entropie, elle, ne l’est pas. Une conséquence de cela est qu’un apport d’énergie est nécessaire si l’on veut faire diminuer l’entropie.

5.1. Désalinisation de l’eau

La désalinisation est un excellent exemple de ce phénomène (Lire : Le dessalement de l’eau de mer). Si l’on ajoute des molécules de sel dans un récipient rempli d’eau potable, elles vont rapidement se diffuser dans le contenant tout entier : c’est l’état d’entropie maximale. Maintenant, supposons que le récipient est un cylindre dans lequel a été placé un piston muni d’une membrane perméable aux molécules d’eau, mais pas aux molécules de sel. L’eau va ainsi pouvoir passer à travers la membrane, contrairement au sel. Au début de l’opération, le cylindre est rempli d’eau potable, le piston étant positionné au milieu de celui-ci. Si l’on ajoute des molécules de sel d’un côté du piston, elles voudront remplir la totalité du contenant. Le piston sera alors soumis à une pression qui le poussera vers le bas. Mutatis Mutandis, si l’on y applique une pression inverse, alors les molécules de sel pourront être récupérées à une extrémité du cylindre. La désalinisation de l’eau a été réalisée, ou plutôt restaurée, au prix de l’effort nécessaire pour pousser le piston. Réduire l’entropie nécessite donc de l’énergie.

5.2. Transferts de chaleur

Autre exemple, les transferts de chaleur. Prenez une bouteille de lait de votre réfrigérateur, versez-vous-en un verre que vous laisserez un moment sur la table, et remettez la bouteille au réfrigérateur. Vous savez sans doute déjà que pour pouvoir boire du lait bien frais, il vaut mieux se dépêcher, car après un certain temps, le verre se retrouvera à température ambiante. Après cela, vous pouvez attendre autant que vous voulez, le lait ne redeviendra jamais froid (Lire : le froid, usages et production). C’est d’ailleurs pour ça que vous avez remis la bouteille au réfrigérateur. Dans un environnement clos, la température cherche toujours à être la plus homogène possible. On dit donc que la chaleur se déplace toujours du chaud vers le froid, et jamais l’inverse.

Mais qu’est-ce que la chaleur exactement ? Une question épineuse à laquelle même Isaac Newton, surement l’un des plus grands génies scientifiques de tous les temps, n’a pas su apporter de réponse. Pour lui, c’était des « particules de chaleur » qui étaient responsables de ce phénomène, une chose qui ne devrait pas vous surprendre, car de telles particules se comporteraient exactement de la même manière que les molécules de sel dans l’eau ou les grains de poussières dans une pièce, en diffusant la chaleur uniformément dans tout l’appartement. Newton appréciait tout particulièrement cette idée de particules, car en effet, il avait déjà formé l’hypothèse selon laquelle la lumière était constituée de « grains de lumières » chargés de la diffuser. Une théorie validée après la découverte des photons. Mais en ce qui concerne la chaleur, aucune particule nouvelle n’est impliquée dans les transferts d’énergie thermique. Comme l’a prouvé Boltzmann bien après, dans la seconde moitié du 19e siècle, les transferts de chaleur dans un gaz sont causés par les mouvements des molécules du gaz lui-même. Du temps de Newton, personne ne croyait sérieusement en l’existence des molécules. Ce statu quo persistera jusqu’aux découvertes de Boltzmann, et même après cela cette théorie continuera d’être débattue (Lire : Thermodynamique, énergie et entropie).

Les mouvements des molécules qui constituent un gaz sont précisément ce qui explique le ballet des particules de poussières passant devant un rayon de soleil. Les molécules gazeuses vont entrer en collision avec la poussière, comme on peut le voir lorsque ses grains flottent à l’air libre (même si l’on ne peut pas voir les molécules, bien trop petites). Pour en revenir aux mécanismes de transfert de chaleur, les molécules se déplacent plus rapidement dans un environnement chaud que dans un environnement froid. Quand des molécules lentes et d’autres plus rapides entrent en collision, ce qui finira par arriver puisqu’elles partagent le même espace, les molécules les plus rapides transfèrent plus d’énergie aux molécules les plus lentes qu’elles n’en récupèrent de ces dernières (énergie cinétique, aussi appelée énergie de mouvement). Ainsi, les différentes vitesses vont progressivement s’uniformiser, de même que les températures. C’est par cette action qu’un système maximise son entropie. La circulation de la chaleur du chaud vers le froid est évidemment très utile, car elle permet de transformer la chaleur en énergie mécanique, qui produira ainsi de l’électricité (Lire : L’électricité, génération et transport).

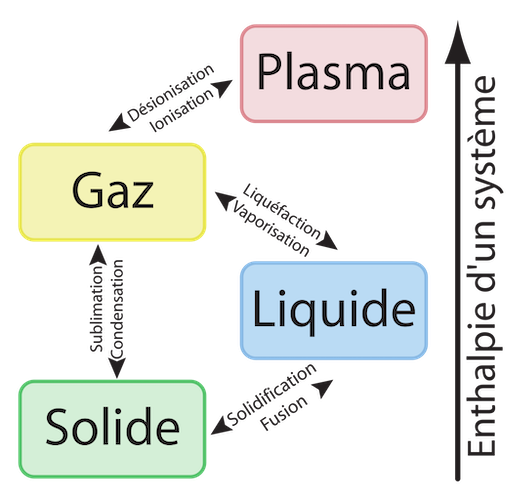

5.3. L’entropie et les états de la matière

La matière existe sous différents états : gazeux, liquide, ou solide. L’état présentant le plus haut niveau de désordre se trouve chez les gaz de faible densité où les molécules peuvent occuper un maximum d’espace. Vient ensuite l’état liquide, beaucoup plus dense et qui laisse moins d’opportunités de déplacement aux molécules qui se déplacent. Et enfin l’état solide, où les molécules sont pratiquement figées (figure 7). D’après cette classification, l’entropie par molécule est à son maximum dans les corps gazeux, et à son minimum dans les corps solides. Quand un gaz se refroidit et se liquéfie, comme par exemple la vapeur qui se transforme en eau, l’entropie est réduite. Elle se réduit encore plus quand on passe de l’état liquide à l’état solide, comme quand l’eau se transforme en glace. Les variations de l’entropie suivant les changements d’états de la matière jouent un rôle majeur dans les changements climatiques de la biosphère.

Figure 7. Etats de la matière. [Source : User:Napy1kenobi based on work from User:JFGOULET, Public domain, via Wikimedia Commons]

Le deuxième principe de la thermodynamique énonce qu’à partir du moment où des petites particules ou des molécules sont émises dans l’atmosphère, elles vont se diffuser et finir par être trouvable n’importe où dans la biosphère (Lire : Thermodynamique, les lois). C’est ainsi que l’entropie arrive à son maximum. La pollution est un phénomène mondial, et non local. Elle n’est en rien semblable à une habitation que l’on garde propre et rangée, car l’état de notre logement ne dépend pas du style de vie de notre voisin. Cette séparation bien pratique est inexistante pour les particules microscopiques et les molécules diffusées à l’air libre, par nous ou par notre voisin. Nous en subirons tous deux les mêmes conséquences. Le problème, ici, nous dépasse totalement. Il n’y a pas de piston magique capable de tout résoudre.

6. La réorganisation de la société

La société doit être réorganisée de manière à pouvoir réduire cette « entropie générale » qui est produite à un niveau bien au-delà de l’entropie créée par les particuliers à leur échelle. Il est tout bonnement absurde d’annoncer aux gens qu’ils doivent réduire leur consommation énergétique, ou pour reprendre notre terminologie, l’entropie qu’ils dégagent, tout en omettant de les informer du fait que leurs actes n’auront aucune influence sur la majorité de l’entropie générée.

Il est extrêmement difficile d’essayer de contrôler cette entropie générale. Pour commencer, il faut déjà comprendre en quelques points quelles en sont les origines.

Par exemple, notre modèle de société urbaine devrait être analysé sous le prisme de l’entropie produite, pour ensuite le comparer à d’autres modèles de société plus disparates. D’un côté, la nourriture et l’énergie doivent être transportées sur de longues distances jusqu’aux centres urbains. La pollution atmosphérique qui en résulte affecte un grand nombre de personnes. Mais d’un autre côté, des économies d’échelles sont possibles. Les immeubles peuvent être mieux isolés que les maisons individuelles (Lire : L’habitat passif et à faible consommation). Les transports publics des grandes villes permettent de réduire l’entropie liée aux déplacements. Il faut également prendre en compte l’entropie des mégalopoles avec leurs zones périurbaines. Ces dernières parviennent en effet à combiner les défauts des sociétés urbaines et rurales à la fois, pour un minimum d’avantages.

N’oublions pas le rôle du gouvernement. Quelles sont les quantités d’entropie produite par le fonctionnement de l’administration, les bâtiments publics, le transport des fonctionnaires, le maintien de la police et de l’armée, les services publics tels que les écoles et les hôpitaux, ou encore l’entretien de la voirie ?

Et ce ne sont là que quelques-unes des questions à garder en tête lorsque l’on cherche à savoir pourquoi l’entropie générale dépasse largement l’entropie créée par les individus.

7. La technologie peut être d’une grande aide

Bien évidemment, les progrès technologiques peuvent réduire l’entropie créée pour la même quantité d’énergie utilisée. Des progrès ont déjà été réalisés, sur lesquels je ne vais pas m’attarder ici car ils sont bien connus du grand public. Relevons tout de même un point important : une technologie relâchant moins d’entropie est en général plus chère que les autres.

On peut par exemple parler de la production électrique. Le moyen le moins couteux de produire de l’électricité à l’heure actuelle est le charbon. C’est également celui qui produit le plus d’entropie par kWh produits. Les véhicules diesel restent bien moins chers que les véhicules hybrides. Les bâtiments bien isolés coûtent plus cher que ceux qui ne le sont pas. Ou encore l’utilisation du bois pour cuisiner et chauffer nos maisons. Ce dernier reste le combustible causant le plus de pollution atmosphérique, aussi bien à l’intérieur qu’à l’extérieur des habitations.

Tous ces exemples prouvent la même chose : de nos jours, cela ne coûte quasiment rien de produire de l’entropie. On pourrait même dire que c’est gratuit, car on ne paye que pour l’énergie consommée, non pas pour l’entropie créée (Lire : Marchés de l’énergie : prix et régulation).

Il devient clair que les pays en voie de développement, qui ne peuvent pas investir dans des technologies plus performantes au niveau entropique, vont continuer d’être ceux qui polluent (et ceux qui sont pollués) le plus. Même parmi les pays développés, il y a des inégalités. Les plus riches peuvent se payer le luxe des technologies les plus « saines ». On peut voir cela en Europe, où les niveaux de pollution suivent la richesse des pays. Berlin est moins polluée que Paris, elle-même moins polluée que Rome et Athènes (Lire : La transition énergétique : un enjeu majeur pour la planète).

Conclusion

Un apport en énergie est nécessaire afin de maintenir les choses en ordre : on prend de l’énergie du monde extérieur, et en échange, on y diffuse de l’entropie. Ici, le monde extérieur serait la biosphère, à l’opposé de nos foyers qui serait « l’intérieur ». Sur le long terme, cette augmentation de l’entropie dans la biosphère pourrait se révéler problématique, tout comme lorsque les ordures et les eaux usées ne sont pas correctement collectées. Prenons un dernier exemple de l’augmentation néfaste de l’entropie : pour vivre, il nous faut de la nourriture (un apport énergétique nécessaire afin de maintenir notre entropie interne à un niveau acceptable), nourriture que nous « brûlons » en utilisant de l’oxygène, une combustion qui nous fait rejeter du dioxyde de carbone. À travers ce processus, l’entropie générale du système (qui comprend nos corps et le contenu de nos habitations, nourriture et oxygène inclus) a augmenté. Si nous gardons nos portes et fenêtres fermées, sans jamais laisser entrer d’air frais, nous finirons par mourir d’asphyxie, et ce malgré le fait que nous disposons encore d’un large stock de nourriture (l’énergie). On a donc bien une crise entropique, et non énergétique. De la même manière, si la biosphère finit par être trop polluée, la vie pourrait devenir impossible malgré les grandes quantités d’énergies qui y resteraient encore exploitables.

Autre fait inquiétant, la plupart de nos moyens actuels de production d’énergie rejettent de l’entropie directement dans la biosphère. Nous avons besoin d’énergie pour maintenir nos habitations dans un état convenable, mais également pour les chauffer durant l’hiver, ou les rafraichir durant l’été, les éclairer pendant la nuit et bien d’autres choses encore. Mais les méthodes de production énergétique émettrices d’entropie, comme les combustibles fossiles, représentent un danger et devraient être employées le moins possible. Il est possible de classifier ces différentes méthodes de production selon le niveau d’entropie qu’elles génèrent. Les pénuries d’énergies sont certes une inquiétude, mais l’augmentation de l’entropie dans la biosphère a le potentiel d’être beaucoup plus grave et imminente.

[1]Voir « La crise entropique ». World Scientific, 2008.